Computer verwandelt Text in Bewegung

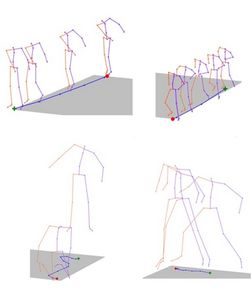

Experten der Carnegie Mellon University (CMU) haben ein Computermodell entwickelt, das geschriebene Sprache in physische Animationen verwandelt. (Bild: CMU)

Eines der großen Themen auf der IFA war künstliche Intelligenz. Die Entwicklung in diesem Bereich schreitet immer schneller voran. Ein Team der Carnegie Mellon University hat nun ein Computermodell entwickelt, das Text in Bewegungen verwandelt.

Experten der Carnegie Mellon University (CMU) haben ein Computermodell entwickelt, das geschriebene Sprache in physische Animationen verwandelt. (Bild: CMU)

Eines der großen Themen auf der IFA war künstliche Intelligenz. Die Entwicklung in diesem Bereich schreitet immer schneller voran. Ein Team der Carnegie Mellon University hat nun ein Computermodell entwickelt, das Text in Bewegungen verwandelt.Wie Medien berichten, haben Experten der Carnegie Mellon University (CMU) ein Computermodell entwickelt, das geschriebene Sprache in physische Animationen verwandelt. Hierfür setzen sie auf ein selbstlernendes neurales System genannt „Joint Language-to-Pose“ (JL2P). „Dieses erkennt in Texten automatisch Passagen, die Bewegungen beschreiben, und ‚übersetzt‘ sie in einfache computergenerierte Trickfilme“, so die Beschreibung. Mit der Methode ließen sich künftig zB Filme einfach direkt aus Drehbüchern generieren, wie es heißt.

„Die Wissenschaft hat bereits gewaltige Fortschritte gemacht, wenn es darum geht, Computern das Verstehen von natürlicher Sprache beizubringen und realistische Animationen anhand einer Reihe von physischen Posen und Bewegungen zu kreieren“, sagt Louis-Philippe Morency, Associate Professor am Language Technologies Institute der CMU, gegenüber Medien. Leider sei es bislang aber noch nicht gelungen, eine Verbindung zwischen der Sprache und den Bewegungen herzustellen. „Mit unserer neuralen Architektur wollen wir diese beiden Welten nun zusammenbringen. Das JL2P-Modell versteht, wie Sprache mit Handlungen, Gesten und Bewegungen zusammenhängt„, so Morency.

Im Moment befindet sich das Ganze allerdings noch in einem sehr frühen Entwicklungsstadium. „Aus Sicht der künstlichen Intelligenz und der theoretischen Grundlagen ist das aber schon jetzt äußerst spannend“, erklärt Morency. Derzeit drehe sich alles um die Animation virtueller Charaktere. „Die Verbindung von Sprache und Bewegung könnte man aber auch bei Robotern nutzen. Wir könnten beispielsweise einem persönlichen Helfer einfach sagen, was er tun soll. Umgekehrt könnte ein Computer so auch erkennen, was in einem Video zu sehen ist“, erläutert der Forscher.

Strenger Lehrplan

Die CMU-Wissenschaftler haben ihrem Computermodell für die Weiterentwicklung ihres JL2P-Ansatzes einen strengen Lehrplan verpasst. Dieser beinhaltete zunächst ein ausführliches Studium von kurzen, einfachen Bewegungssequenzen – zB eine einzelne Person, die gerade nach vorne geht. Anschließend wurde die Komplexität der Bewegungen kontinuierlich gesteigert, bis auch schwierigere, längere Abläufe richtig erfasst werden konnten.

„Verben und Adverben beschreiben die Bewegung und die Geschwindigkeit beziehungsweise Beschleunigung einer Aktion, während Haupt- und Eigenschaftswörter Rückschlüsse auf Orte und Bewegungsrichtungen erlauben“, schildert Projektmitarbeiterin Chaitanya Ahuja die Funktionsweise. „Das Ziel ist letztendlich, komplexe Sequenzen zu animieren, bei denen mehrere Aktionen gleichzeitig oder hintereinander stattfinden.“

Kommentare